Amazon, secondo un rapporto del Financial Times, sta lavorando ad un chip di intelligenza artificiale (AI) per ridurre la propria dipendenza da NVIDIA, leader nel settore delle GPU ad alte prestazioni per carichi di lavoro AI. Amazon ha già sviluppato diversi processori interni per i propri data center e questo nuovo impegno fa parte di un investimento del 2015 in una startup di progettazione di chip. Si prevede che il mese prossimo l’azienda fornirà dettagli sui propri processori AI personalizzati, in particolare sulla gamma di chip Trainium.

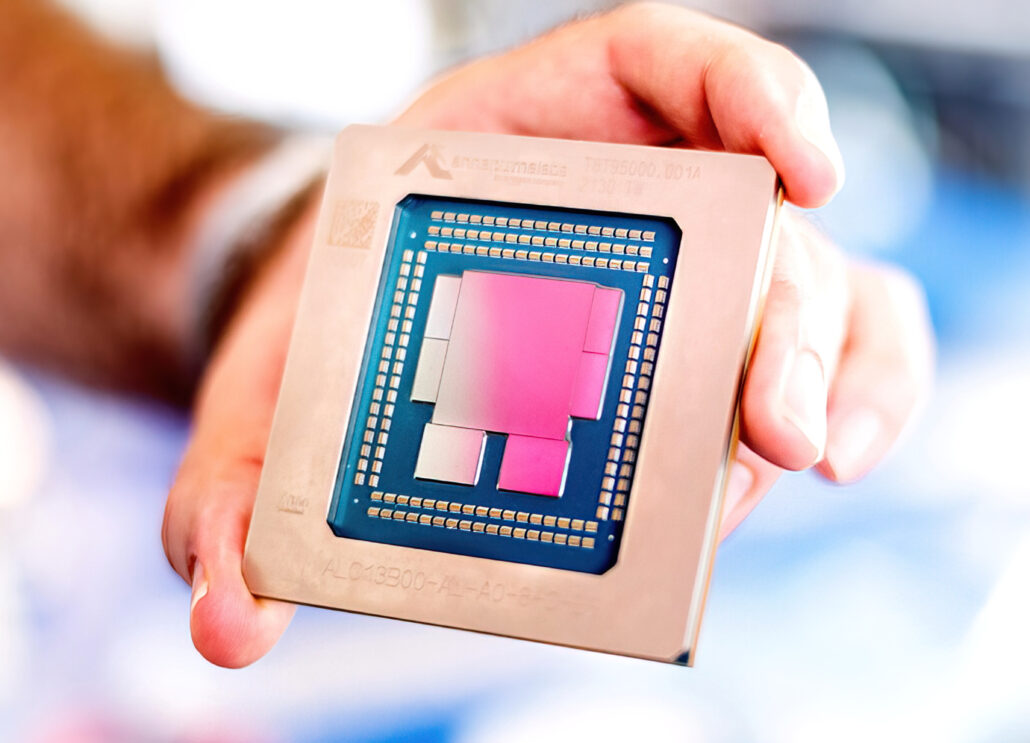

I chip in questione sono sviluppati dai laboratori Annapurna di Amazon e sono attualmente utilizzati anche da Anthropic, partner AI principale di Amazon e sostenuto da Microsoft. Anthropic, rivale di OpenAI, offre ad Amazon l’accesso al suo modello AI Claude.

Questo passo è solo l’ultimo segnale di un trend nel settore tecnologico: ridurre la dipendenza dalle GPU NVIDIA, estremamente richieste e costose a causa della loro capacità di gestire i carichi di lavoro AI più complessi. Per Amazon, creare chip interni non solo significa maggiore indipendenza, ma anche la possibilità di ridurre i costi. Grazie all’acquisizione di Annapurna, Amazon ha già sviluppato processori come i Graviton, destinati a ridurre i costi dei carichi di lavoro sui data center, tradizionalmente gestiti da chip di AMD e Intel.

I processori Graviton si affiancano ora ai Trainium, progettati per supportare grandi modelli linguistici e aggiornati con la versione Trainium2, presentata nel novembre 2023. Sebbene Trainium2 abbia risentito di limitazioni di fornitura, è già in uso da parte di Anthropic.

Amazon collabora con Alchip per la progettazione dei suoi chip, prodotti dalla Taiwan Semiconductor Manufacturing Company (TSMC). Lo scorso anno, Amazon ha dichiarato che oltre 50.000 clienti AWS stavano utilizzando i chip Graviton.

Anche altre grandi aziende tecnologiche come Alphabet e Meta stanno sviluppando chip AI in-house (fatti in casa) per ridurre la dipendenza da NVIDIA. Ad esempio, Meta ha introdotto il suo acceleratore MTIA di seconda generazione e Google ha recentemente presentato il suo chip TPU, Trillium, che promette prestazioni di training AI e inferenza significativamente migliorate rispetto alle versioni precedenti.

0 commenti